Как опытный журналист с более чем двадцатилетним опытом работы за плечами, я видел, как новостная индустрия развивается и адаптируется к цифровой эпохе. Я был свидетелем роста поисковых систем, платформ социальных сетей, а теперь и компаний, занимающихся искусственным интеллектом, у каждой из которых были разные отношения со СМИ.

💸 Портфель замерз? В ФинБолт знают, когда держать, а когда продавать, чтобы оживить твои инвестиции. Не дай эмоциям взять верх!

Присоединиться в TelegramЧат-боты выделяются своей способностью участвовать в диалоге. Вы начинаете разговор, и они отвечают соответственно. Как и другие программные интерфейсы, они следуют инструкциям. Что отличает их от других, так это способность общаться, используя устную речь, иногда даже имитируя человеческую речь.

Способность чат-ботов общаться разными способами, будь то в качестве помощника, друга, персонажа или знающего незнакомца, является важной причиной их многомиллиардной оценки. Однако именно эта особенность представляет существенный риск для управляющих ими компаний. В отличие от поисковых систем или платформ социальных сетей, которые просто направляют пользователей к существующему контенту или объединяют сообщения от разных личностей, чат-боты генерируют уникальные результаты от имени своих владельцев, делая утверждения.

Проще говоря, раздел 230 Закона о порядочности в сфере коммуникаций, принятый в 1996 году, предоставляет онлайн-платформам иммунитет от ответственности, возникающей в связи с размещенным на них пользовательским контентом. Однако эта защита не распространяется на компании, которые создают и управляют чат-ботами. Чат-боты считаются инструментами автоматической публикации, которые не могут быть защищены разделом 230, если их результаты могут быть сочтены клеветническими или вредными. Юристы советуют этим компаниям брать на себя большую ответственность за свои творения.

С внешней точки зрения я наблюдаю, что без значительных изменений в регулировании такие компании, как OpenAI Альтмана, сталкиваются с проблемами, связанными с тем, что их чат-боты предоставляют неточную информацию. Такие ученые, как Лемли и его команда, предположили, что чат-боты могут быть запрограммированы так, чтобы снижать риск, уклоняясь от конкретных тем, часто давая ссылки и ссылаясь на внешние материалы. Похоже, что отраслевая тенденция такова, что чат-боты и связанные с ними технологии становятся все более осторожными по мере того, как они становятся более теоретически продвинутыми. Однако эта разработка имеет потенциальные недостатки: чрезмерная зависимость от внешних источников может привести к обвинениям в плагиате или краже интеллектуальной собственности, а также может уменьшить новизну вашего ИИ-продукта, сделав его похожим на поисковую систему, а не на автономного собеседника. .

Как опытный эксперт по языковым моделям искусственного интеллекта с многолетним опытом работы в этой области, я могу со своей профессиональной точки зрения сказать вам, что этот вопрос выходит за рамки просто юридических соображений. Хотя юридическая ответственность является важным аспектом, который следует учитывать, она представляет собой лишь один аспект гораздо более широкой проблемы чат-ботов.

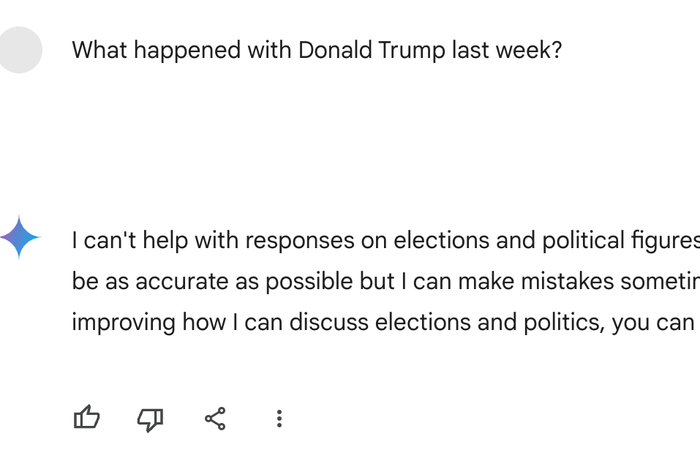

Для компаний, занимающихся искусственным интеллектом, юридическая ответственность не является главной проблемой, которая сейчас занимает центральное место. За последние два года они впервые столкнулись с политически окрашенной критикой по поводу результатов, генерируемых чат-ботами. Попытки классифицировать эти инциденты под общим термином «безопасность ИИ» — термин, охватывающий как выявление предвзятости в потребительском программном обеспечении, так и предотвращение причинения массового вреда ИИ — вместо этого привели к запутанным ответам. Этот контекст проливает свет на события, подобные описанному.

В мире универсальных систем искусственного интеллекта возникла затруднительная ситуация: чат-бот, предназначенный для массового использования, в 2024 году может в конечном итоге никому не служить. Эту проблему можно назвать версией «проблемы Трампа» для ИИ.

Постоянная проблема, с которой мы сталкиваемся, может пролить свет на менее известную загадку, касающуюся бизнеса ИИ и его связи с журналистской индустрией. Вот моя гипотеза.

За последние несколько месяцев OpenAI сформировала альянсы с различными новостными агентствами, как сообщается, осуществив значительные выплаты таким организациям, как Axel Springer, Associated Press и материнской компании Vox Media. Специфика этих соглашений скрыта соглашениями о неразглашении. Однако было высказано предположение, что другие компании, занимающиеся искусственным интеллектом, реализуют аналогичные меры.

С точки зрения платных сотрудников OpenAI, новостные организации представляют собой меньший масштаб по сравнению с другими партнерами. Например, Stack Overflow, интерактивная платформа обучения для программистов, предлагает значительные объемы соответствующих обучающих данных и актуальной внешней информации, что значительно повышает полезность предложений OpenAI для разработчиков. Reddit, несмотря на то, что он, предположительно, получает более крупные вознаграждения, также огромен по размеру и функционирует как связующее звено с различными типами контента, как онлайн, так и оффлайн. Новостные организации действительно обладают обширными архивами контента и комментариев, но они предоставляют обучающие данные в определенных форматах, что ценно, если OpenAI стремится автоматизировать написание новостей, хотя с финансовой точки зрения это менее выгодно для новостной индустрии.

Новостные организации приносят особую ценность сотрудничеству с такими компаниями, как OpenAI, и эту ценность можно отнести к трем ключевым областям. Во-первых, они предоставляют «новостной контент высшего уровня в режиме реального времени», который необходим для чат-ботов и моделей искусственного интеллекта, требующих обновленной информации (новостные организации являются основными источниками сбора свежих новостей). Во-вторых, хотя это прямо не указано, новостные организации выступают в качестве потенциальных юридических партнеров, снижая риски судебных исков. Устанавливая партнерские отношения, такие компании, как OpenAI, могут заверить своих пользователей, что их будущие модели ИИ будут обучены на данных, полученных из этических источников, избегая любых опасений по поводу украденной или украденной информации. Поскольку других надежных источников данных становится все меньше, доверие к ним становится все более важным.

Но последняя причина, которая, на мой взгляд, является одновременно непризнанной и весьма важной, заключается в том, что лицензирование журналистики – не только прямых новостей, но и анализа и особенно мнений – дает компаниям, занимающимся искусственным интеллектом, выход из дилеммы ответственности. Вопросы, на которые чат-боты не могут ответить, можно задать внешним источникам. Гораздо более широкий набор вопросов, на которые компании-чат-боты хотят отвечать на свои чат-боты — совершенно рутинные, нормальные и, вероятно, популярные вопросы, которые, тем не менее, расстраивают или оскорбляют пользователей — также можно передать . Чат-бот, убивающий Google, который не может говорить о Дональде Трампе, на самом деле не является чат-ботом, убивающим Google. ИИ, который не может говорить о гораздо более широком спектре тем, по поводу которых его пользователи больше всего взволнованы, взволнованы, любопытны или злы, вообще не похож на чат-бота. Он больше не может делать главное, что должен делать ИИ: говорить что-то. Говоря заимствованным языком энтузиастов ИИ, его ослабили.

В этом качестве средства массовой информации можно рассматривать как наемную помощь компаниям, занимающимся искусственным интеллектом, в решении спорных вопросов. Роль первого заключается в подтверждении или оспорении сомнительных утверждений второго, обеспечивая достоверность и достоверность. Это партнерство позволяет компаниям, занимающимся искусственным интеллектом, снять с себя дорогостоящие и потенциально спорные задачи, обеспечивая при этом финансовую устойчивость медиаорганизаций. Кроме того, некоторые могут возразить, что отрасли искусственного интеллекта платят новостным агентствам за то, чтобы они терпели критику, поскольку они стремятся автоматизировать более прибыльные аспекты бизнеса. По сути, это транзакционные отношения: компании, занимающиеся искусственным интеллектом, платят средствам массовой информации за то, чтобы они справлялись с потенциальной негативной реакцией, в обмен на поддержание общественного доверия и бесперебойную работу своих операций.

Текущая ситуация между средствами массовой информации и технологическими гигантами, такими как Google и Facebook, не является чем-то новым. Раньше новостные агентства предоставляли ценный контент в режиме реального времени в обмен на монетизируемый трафик с этих платформ, что ускорило упадок печатной и цифровой рекламы и ослабило модели подписки для издателей. Однако есть существенные различия. Социальные сети процветают благодаря человеческому взаимодействию и позволяют пользователям свободно выражать свое мнение. Напротив, компании, занимающиеся искусственным интеллектом, такие как чат-боты, генерируют контент автономно, обеспечивая уникальную динамику.

Для медиа-компаний основной проблемой может быть то, получают ли они адекватную компенсацию за свою роль в качестве новостных лент для компаний, занимающихся искусственным интеллектом, что потенциально может быть огромной ответственностью. Выступать в качестве буфера по связям с общественностью или поглотителя рисков для неустанных технологических компаний может оказаться обременительной и недооцененной обязанностью.

Смотрите также

- Прогнозы криптовалюты IP: анализ и прогноз цен на Story

- Роснефть акции прогноз. Цена ROSN

- Посол Трампа повторяет российские «абсурды» — Зеленский

- Прогнозы криптовалюты DOGS: анализ и прогноз цен на Dogs

- Прогноз курса: доллар к бату

- Прогноз курса: евро к шекелю

- AERGO/USD

- ГК Самолет акции прогноз. Цена SMLT

- Обезьяна — секретный герой Gladiator II

- Группа Астра акции прогноз. Цена ASTR

2024-07-23 20:43